Grâce à 4 modélisations, les chercheurs ont pu démontrer la différence qui existait entre la catégorisation et la coordonnée des représentations spatiales. Les réseaux qui étaient dissociés afin que les neurones artificiels contribuent soit pour une tâche, soit pour l'autre, avaient de meilleurs résultats que les réseaux non dissociés. Les résultats étaient plus difficiles à obtenir lorsque la tâche était plus complexe. Ceci est peut être une base pour expliquer la latéralisation des deux processus (catégorisation et coordonnée spatiale). Peut être que dans le cerveau, du coup, l'asymétrie des deux processus serait visible avec des tâches avec un contraste élevé (comme ici, les résultats ont été plus difficiles à obtenir avec quand la tâche était plus fine, moins contrasté entre les différents éléments).

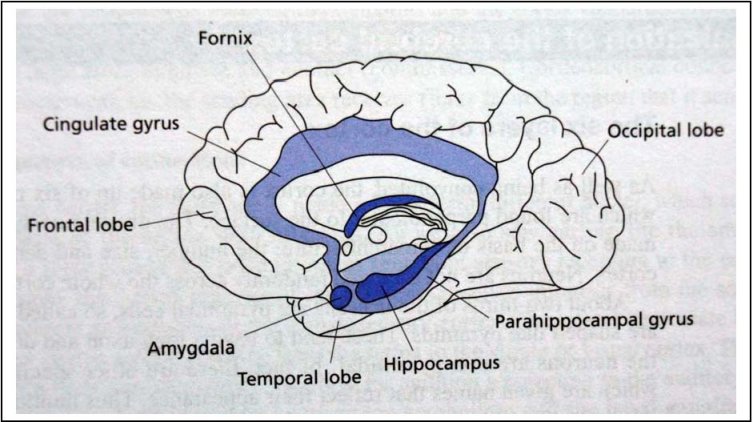

Dans les théories issues des neurosciences, le cerveau fonctionnerait en systèmes, divisés en systèmes plus petits. A chaque niveau, il y aurait des connexions pour faire fonctionner les systèmes ensembles. C'est notamment le cas pour le lobe pariétal et le lobe temporal. Le lobe pariétal encode les informations spatiales, et le lobe temporal encode les propriétés des objets. Les auteurs attestent que le lobe pariétal, et donc les informations spatiales, sont divisées en deux sous-système: la catégorisation et la coordonnée. Ils sont partis pour cela de la considération qu'un humain peut faire deux choses bien distinctes avec sa représentation spatiale: pour diriger l'action vers un objet, et donc savoir où il est situé exactement (c'est la coordonnée, qui serait plus l'apanage du cerveau droit); pour savoir où sont les objets les uns par rapport aux autres (c'est la catégorisation, gérée par le cerveau gauche).

Etude 1

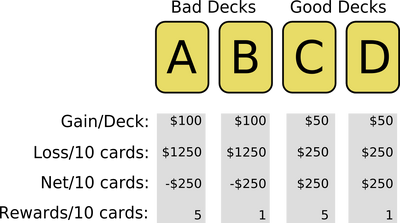

Ils ont prit comme tâche de décision de la catégorisation, une tâche de décision au dessus/en dessous, où le réseau devait décider si un point était au dessus ou en dessous une barre, pour cela, il devait regrouper les pixels en catégories (au dessus, en dessous, la zone de la barre). La tâche de coordonnée était de décider si ce même point était à plus ou moins 4 unités (pixels) de la barre, où là, le réseau devait être plus précis.

Ils ont regardé le nombre d'erreurs du réseau après une période d'entrainement.

La partie 1 a utilisé des réseaux soit reliés, soit dissociés pour effectuer les tâches soit ensembles, soit chacun s'attribuant une tâche.

La partie 2 est là pour vérifier que la facilité des réseaux dissociés n'est pas due à cette tâche spécifiquement.

Partie 1

Matériel

Ils ont utilisés des réseaux standards à trois niveaux, de 28 unités input et 4 unités output (2 pour chaque tâche) et avec un nombre d'unités cachées de 8 à 17. Les réseaux dissocié et non dissociés étaient identiques hormis pour la séparation en deux. Une modélisation des réseaux est présentée sur le schéma de gauche.

Sur le design de la tâche elle même, il y avait une ligne de plusieurs unités, soit actives, soit inactives (des pixels). Un point était représenté par l'allumage d'un pixel à n'importe laquelle des 8 positions en dessus et des 8 positions en dessous. Selon la position, la tâche était néanmoins plus ou moins difficile à réaliser.

La réponse était correcte pour la tâche de catégorisation si il avait identifié le point dans l'une des 8 positions grisées sur le schéma (représenté par Below / Above). Pour la tâche de coordonnée, il s'agissait de savoir si le point allumé était à plus ou moins de 4 éléments de la barre.

Ils ont testé 18 réseaux de chaque type, dans 50 essais de 80 stimuli chacun. Cela donne beaucoup de données, mais c'est ce qu'il faut en modélisation.

Résultats

Les résultats ont montré que les réseaux dissociés étaient plus efficaces pour effectuer les deux tâches, ce qui indiquerait que les deux tâches sont bien gérées différemment et sont donc distinctes.

Partie 2

Méthode

Ils ont voulu voir dans cette deuxième partie de l'expérience si la tâche de coordonnée était bien le dernier sous-système, ou si à nouveau, un réseau dissocié serait plus performant, attestant alors de deux tâches de coordonnée en fait différentes.

Les deux tâches qui sont utilisées sont de savoir si le point est dans 2 éléments plus haut ou plus bas que la barre, ou s'il est dans 6 éléments plus haut ou plus bas que la barre. Cela correspondrait, dans le cerveau, à savoir si la perception d'une différence entre 10 et 20 cm relève du même sous-système qu'une différence entre 10 et 20 m.

Résultats

Le réseau non dissocié produisait moins d'erreurs que le réseau dissocié, ce qui atteste bien que discriminer si c'est à 10 ou 20 cm est en fait la même chose que discriminer si c'est à 10 ou 20 mètres, en tout cas en terme de sous-systèmes cognitifs impliqués. Il n'y a donc bien qu'un seul sous-système de Coordonnés.

Discussion

Ces simulations indiquent que la catégorisation spatiale et de coordonnés sont deux tâches distinctes, et que des réseaux spécialisés sont plus à même d'être efficace que si un seul réseau s'occupait des deux tâches. Cela n'implique cependant pas nécessairement que le cerveau soit organisé de la même manière avec deux sous-systèmes distincts, seulement que ce serait plus efficace s'il l'était.

Etude 2

Dans cette étude, ils ont utilisé des réseaux pour savoir à peu près la même chose que pour la deuxième partie de l'étude 1, mais en rajoutant la tâche de catégorisation, et non uniquement la tâche de coordonné. Ils ont utilisé pour cela les notions de "easy" et "difficult" que l'on voit sur le schéma de l'expérience.

Pour la tâche de catégorisation, c'était facile quand le point était loin de la barre et difficile quand c'était proche.

Pour la tâche de coordonnés, c'était facile quand le point était loin de la distance centrale (à 4 unitésde la barre) et difficile quand c'était proche de ce point.

Méthode

Le matériel était le même que pour l'étude 1, à la différence près qu'ils n'ont utilisé que des réseaux non dissociés, avec deux unités de sorti et qu'ils ont fait varier le nombre d'unités cachées entre 6 et 12.

La tâche de jugement catégoriel était divisée en facile et difficile. La tâche facile était quand le point était à plus de 4 unités de la barre. La tâche difficile quand le point était à moins de 4 unités de la barre.

La tâche de jugement coordonné était également divisée en facile et difficile. Dans la condition facile, le point était à plus de 2 unités du centre de la partie haute ou basse, et dans la condition difficile, à moins de 2 unités.

Les réseaux étaient entrainés avec 40 patterns d'entrée.

Ils ont testé 25 réseaux de chaque type dans chaque condition. Ils ont mesuré le taux d'erreur non pas après 50 essais, comme dans l'étude 1, mais après 30, pour avoir plus de différences.

Résultats

Les deux tâches, que ce soit catégorielle ou coordonnée montrent une augmentation de l'erreur avec la difficulté.

Discussion

Les difficultés de la tâches, la subtilité de celle-ci, la façon dont elle a besoin d'être précise influence les deux types de tâches, et le pourcentage d'erreur dans chacune augmente avec la précision demandée.

Cela correspond aux difficultés rencontrées chez les sujets humains.

Etude 3

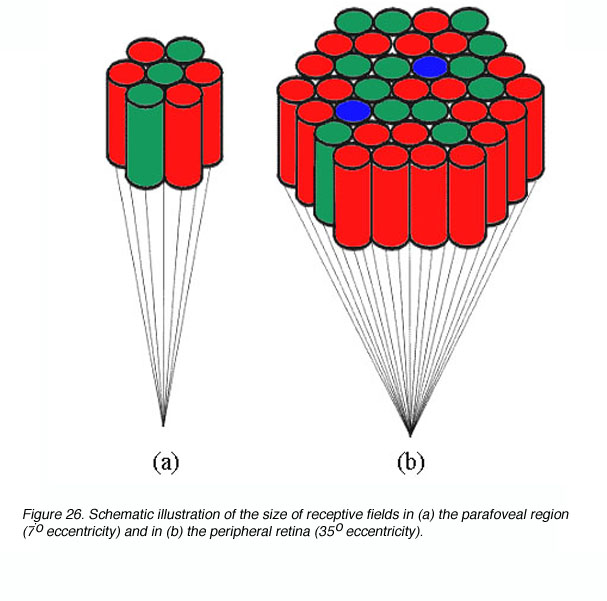

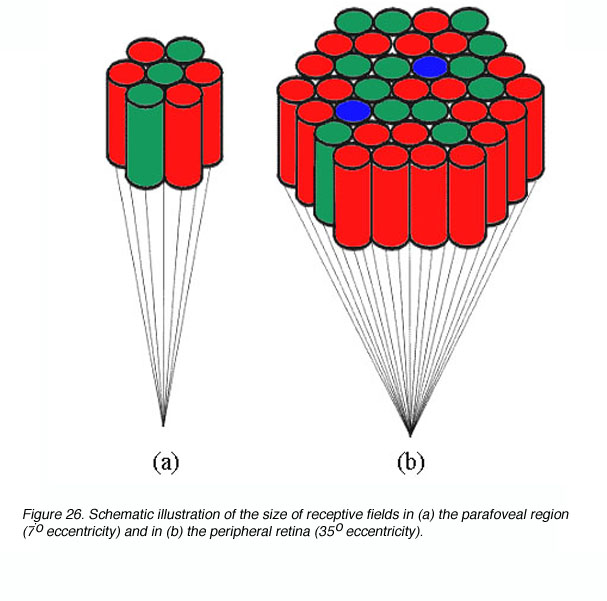

Les auteurs pensent que les représentation coordonnées jouent un rôle particulier dans le contrôle des actions, et les représentations catégorielles jouent un rôle particulier dans la reconnaissance et l'identification des objets. Là dessus, les auteurs ont fait le lien avec l'idée que les neurones de l'hémisphère droit de l'aire visuelle ont des champs récepteurs plutôt larges, et ceux de l'hémisphère gauche ont des champs récepteurs plutôt restreints. L'idée est de dire que chaque hémisphère s'occupe d'une tâche (coordonnées ou catégorisation) et que son aptitude à réussir cette tâche est directement liée au fait qu'il ait des champs récepteurs plus ou moins larges. Un champ récepteur large serait utile pour percevoir l'ensemble de l'espace, et également permettre d'initier un mouvement rapidement, dans un processus pré-attentif. Le champ récepteur restreint permettrait au contraire de créer des "zones" générales dans lequel placer les stimuli de manière grossière. (Cela va de pair avec l'idée que quand il y a de larges récepteurs, les champs se chevauchent, et ont donc une meilleure sensibilité: plusieurs neurones s'occupent de la même zone de l'espace).

Ainsi, ils ont étudié si les tâches étaient mieux réussies avec un champ récepteur large ou restreint. Dans la première partie de l'étude, ils ont étudié les champs récepteurs des unités cachées, et dans la partie 2, ils ont fixé ces champs avant les unités Input, en rajoutant d'eux même une couche.

Partie 1

Méthode

Deux réseaux ont été construits: un pour chaque tâche. C'était les mêmes que pour l'étude 2, mais avec un nombre d'unités cachées fixe: 10. Ils faisaient la tâche difficile et facile, et non l'une des deux. L'entrainement était effectué jusqu'à ce que les réseaux aient un pourcentage d'erreur proche de 0.

Résultats

Les champs récepteurs développés dans le réseau qui faisait la tâche de coordonnées étaient plus larges que ceux de la tâche de catégorisation.

Discussion

Les réseaux de la tâche de coordonnée ont développé tout seuls des champs récepteurs plus larges, et les réseaux de la tâche de catégorisation ont développé des champs plus petits. Cela correspond aux hypothèses.

Partie 2

Méthode

Les réseaux étaient les mêmes que ceux de l'étude 2, mais ils ont rajouté une couche d'unités "rétiniennes" avec une force fixée et un nombre de connexions pour chaque unité input fixé également. les couches étaient constituées de 28 unités pour la couche "rétinienne", 14 unités pour la couche "Input", 10 unités cachées et 2 unités "output". On peut le symboliser comme sur le schéma ci-contre. La quantité d'unités afférentes à chaque unité "input" formaient le champ récepteur plus ou moins étendu, selon la force de la connexion de chaque unité "rétinienne".

Pour voir à quoi correspond un champ récepteur au niveau de la rétine, voir le schéma de droite (cela se passe au niveau des yeux).

Résultats

A nouveau comme prévu, les champs récepteurs larges facilitaient la tâche de jugement de coordonnées, et inversement pour la tâche de catégorisation.

Discussion

Ces résultats correspondent aux observations faites chez les sujets humains. Cela correspond à l'idée que le l'hémisphère gauche serait plus performant pour la tâche de catégorisation parce qu'il aurait des champs récepteurs plus restreints, et que l'hémisphère droit serait plus apte à faire la tâche de coordonnées, à cause de ses champs récepteurs visuels plus larges. L'idée est que l'avantage des champs visuels restreints pour la tâche de catégorisation ne sera présent qu'à l'intérieur de ces champs visuels, et non à l'extérieur, dans les zones non couvertes.

Etude 4

Certes, les tâches sont mieux effectuées selon la taille du champ récepteur, mais dans le cerveau, il n'y a pas que des champs larges à droite et des champs restreints à gauche, c'est plutôt mixé, et l'effet du champ récepteur pourrait être noyé dans la masse de neurones qui traitent l'information. Ceci expliquerait que les différences entre hémisphères pour ces tâches ne s'observent pas tout le temps, mais seulement avec des stimuli dégradés. Ils ont donc étudié des réseaux avec des champs récepteurs homogènes, ou hétérogènes.

Méthode

Ils ont reprit le même matériel que dans l'étude 3, en doublant juste le nombre d'unités "input". Ils ont séparé les réseaux selon que leurs champs étant homogènes ou hétérogènes, et selon s'ils étaient larges ou restreints, ce qui nous donne 4 types de réseaux différents.

Résultats

- Les réseaux hétérogènes réussissent mieux la tâche de catégorisation quand ils ont une majorité de champs récepteurs petits que grand.

- Les réseaux hétérogènes réussissaient la tâche de coordonnées aussi bien quelques soient les tailles des champs récepteurs.

- Les réseaux hétérogènes étaient plus efficaces pour la tâche de coordonnées que pour la tâche de catégorisation.

- Les réseaux homogènes n'avaient pas de différence entre la taille des champs et la tâche: la tâche de catégorisation était réussie aussi bien avec des champs récepteurs grands ou petits, tout comme la tâche de coordonnées.

- Les réseaux homogènes étaient plus efficaces pour la tâche de coordonnées que pour la catégorisation.

Discussion

Avoir un plus grand nombre d'unités élimine donc l'avantage d'avoir des champs récepteurs plus grands pour encoder les informations précises. Cela explique les données sur les humains comme quoi on n'observe pas de différence pour des tâches normales, qu'il fallait avoir des stimuli dégradés, donc avec moins d'unités qui les perçoivent pour observer des différences entre les hémisphères et les tâches.

Discussion Générale

Ces résultats apportent une preuve de la différence entre les deux tâche de catégorisation spatiale et de représentation des coordonnées. Les réseaux qui encodent ces deux tâches sont différents, et on peut expliquer grâce à la taille des champs récepteurs la facilité de l'hémisphère droit pour traiter des coordonnées et la facilité de l'hémisphère gauche pour traiter une catégorisation spatiale, ainsi que pourquoi on n'observe pas cette différence pour des stimuli à fort contraste, qui activent plus de neurones input.

Ces deux sous-systèmes partagent un grand nombre de similarités, mais les quelques différences qu'ils ont font leur spécificité. Cela reste cependant des sous-systèmes du même système de représentation spatiale.

On peut également présumer avec ces résultats (grâce aux résultats de l'étude 4 notamment) que les deux hémisphères sont capables d'effectuer les deux types de tâches, mais qu'il y en aura un plus fort que l'autre dans les situations difficiles à juger.

Il existe

5 principes sur l'activation des neurones dans le cerveau:

Division of labor: Il est plus efficace d'effectuer des cartographies de l'espace différentes avec des réseaux différents.

Weak modularity: Un sous-système peu effectuer plusieurs opérations similaires (cf. l'exemple d'avoir les coordonnées à 10-20cm ou à 10-20m).

Constraint satisfaction: Une information précise est encodée grâce à plusieurs critères activés en même temps.

Concurrent processing: Des sous-systèmes activés en parallèles sont utilisés pour faire plusieurs types de cartographie de l'espace.

Opportunism: Les mécanismes qui ont été spécialisés pour une tâche peuvent toujours changer et être re-spécialisés dans une autre.

Source: Kosslyn, S. M., Chabris, C. F., Marsolek, C. J., & Koenig, O. (1992). Categorical versus Coordinate spatial relations: computational analyses and computer simulations, in Journal of experimental psychology, 18 (2), 562-577